Numa recente edição da

Astronomy and Geophysics (A&G), Henrik Svensmark cunhou um novo termo:

'cosmoclimatologia'. Eu acho que 'cosmoclimatologia' é um nome bom e renovador para qualquer coisa que combine nosso cosmos com nosso clima. Contudo, achei muito desapontador todos os outros aspectos do artigo. Já cobrimos a maioria desses tópicos antes, mas o artigo da A&G nos dá alguns novos aspectos para discutir. Além do mais, Svensmark é o diretor do Centro de Pesquisa sobre o Sol-Clima, do Centro Nacional Espacial Holandês, e portanto é muito influente. Ele é também co-autor de um livro recente com

Nigel Calder que

recebeu alguma atenção. Ainda mais,

um experimento de laboratório seu também ganhou notoriedade. Parece que a forçante solar é uma das

últimas trincheiras dos céticos no debate sobre mudanças climáticas. Na minha visão, o trabalho da A&G merece então comentários, dado que os mesmos velhos e ultrapassados argumentos resurgem sem se discutir os temores dos críticos.

Existem algumas questões que tornam o trabalho da A&G realmente pobre ao meu ver. Uma delas é a omissão de responder as velhas críticas da hipótese de que raios cósmicos galáticos (sigla em inglês GCR) mudam nosso clima modulando as nuvens. (veja aqui, aqui e aqui). Svensmark é muito vago sobre a falta de tendência nos GCR ou em outras variáveis solares desde 1952. Eu o questionei sobre isso numa conferência da Sociedade Européia de Geofísica (sigla em inglês EGS) em Nice há alguns anos atrás, e publiquei também um trabalho sobre esse ponto. O artigo da A&G seleciona as referências, sem no entanto responder as sérias críticas enchaminhadas por Damon & Laut (2004), Laut (2003) e eu mesmo. Para ser honesto, o trabalho crítico de Kristjansson e Kristiansen (2000) é citado, embora somente para dizer que a própria conclusão de Svensmark seja "um achado contra-intuitivo para alguns críticos". O tratamento restante dos aspectos críticos no artigo da A&G é sem maiores qualificações, a não ser a seguinte passagem (minha ênfase):

A principal objeção para a idéia de que raios cósmicos têm influência na cobertura de nuvens veio de meteorologistas os quais insistiram que não haveria mecanismo capaz de produzir isso. Por outro lado, alguns físicos atmosféricos concluiram que a observação e a teoria falharam em considerar satisfatoriamente a origem das partículas de aerossóis sem as quais a água não condensa para formar nuvens.

Eu não acho que isso seja uma piada, e não sei se o artigo tenta criar uma classificação de críticos e adeptos de suas idéias como 'meteorologistas' e 'físicos' (eu sou físico). Mas este é um detalhe diminuto comparado com os conceitos errados incluídos nessa passagem. Existem muitas 'sementes' no ar que podem condensar água, também conhecidas como núcleos de condensação de nuvens (sigla em inglês CCN). De acordo com meu velho livro 'A Short Course in Cloud Physics' de Rogers e Yau (1989, p. 95, terceira edição): "Núcleos de condensação de algum tipo estão sempre presentes na atmosfera em grande número: nuvens se formam sempre que há movimentos verticais de ar e suficiente umidade". Os CCN consistem na maioria das vezes de poeira mineral, sal marinho ou material sulfuroso.

Eu tenho sérias dúvidas sobre a seguinte – vaga ainda que falsa – afirmação colocada adiante no artigo da A&G :

Tentativas de mostrar que certos detalhes nos dados climáticos confirmam a forçante de efeito estufa (por exemplo Mitchell et al., 2001) têm sido menos conclusivas. Em contraste, a hipótese de mudanças nas nuvens devido aos raios cósmicos que ajuda a forçar uma mudança climática prevê um sinal distinto que é na verdade muito facilmente observado mais como uma exceção do que uma regra.

De novo, sem mais qualificações ou referências. A ironia é que Svensmark ignora (além da falta de tendência dos GCR) o fato de que as temperaturas noturnas têm subido mais rápido do que as temperaturas diurnas, ponto pelo qual eu o incomodei numa Reunião Nordica de Meteorologia em Copenhagen em 2002. Um jornalista do Jyllands Posten presente na conferência captou a mensagem, de modo que minha crítica repercurtiu num jornal no dia seguinte ("Klimaforskere i åben krig" [tradução 'Pesquisadores do clima em pé de querra], 28 de maio, 2002): É difícil explicar como um aquecimento causado pela diminuição do albedo poderia ser mais forte no lado escuro (noite) do planeta.

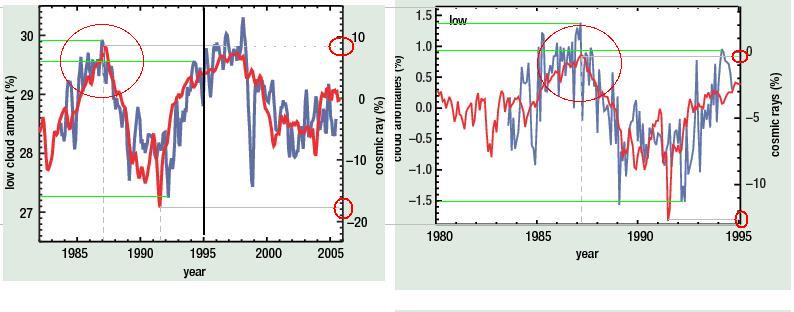

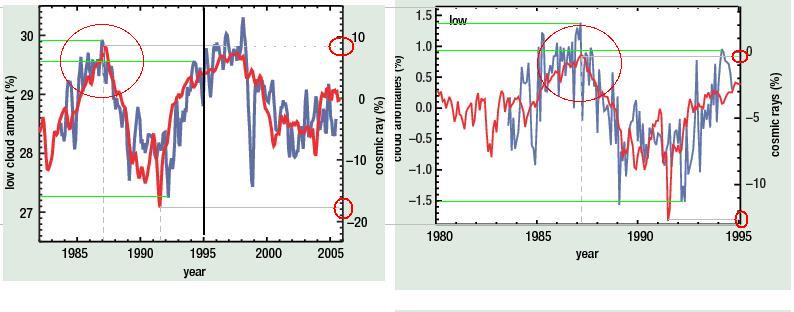

Um outro quebra-cabeça está na surpreendentemente boa correlação entre nuvens e GCR (veja figura abaixo), tendo em vista que nuvens altas (cobertura média global de ~13%) ou nuvens intermediárias (~20%) que não são influenciadas por GCR, mascaram as nuvens baixas (que representam entre 28% e 30% do globo). É de fato supreendente o bom ajuste entre as duas curvas no trabalho da A&G (reproduzido abaixo), considerando a estrutura de tempo nas curvas de altas, intermediárias e baixas nuvens, e que os satélites não podem ver as nuvens de baixo nível onde acima existem nuvens de níveis mais altos bloqueando a visão. O fato é que as variações são pequenas (~1% em amplitude!) comparadas com a área total, sugerindo que o efeito de sobreposição/mascaramento por nuvens altas deve ser muito pequeno para uma alta correlação acontecer através de nuvens elevadas. Mesmo se hipoteticamente as nuvens fossem completamente determinadas por GCR, poderíamos esperar ver uma deterioração da correlação se vista por cima, devido à presença de nuvens altas não influenciadas por GCR. Outra questão é que os dados de nuvens usados nessa análise foram somente baseados no canal infra-vermelho (sigla em inglês IR), e uma melhor análise deveria incluir as observações no visível também, mas se os dados do visível são incluídos, então a correlação seria menor (comunicação pessoal, Jørn Kristjansen).

Numa nota mais técnica, parece haver inconsistências entre o GCR apresentado nas Figuras 2 e 3 do artigo da A&G (veja os círculos vermelhos no gráfico acima), e isto não é explicado no artigo. Na Fig. 3 (gráfico da esquerda acima) o GCR aumentou em 10% mas o máximo valor é cerca de 0% na Fig. 2 (gráfico da direita acima), e o mínimo valor é aproximadamente de -18% na Fig 3 mas somente -13% na Fig 2. Parece que as Fig 2 & 3 foram baseadas em fontes diferentes de dados. Para ser justo, ambos GCR e ISCCP são continuamente atualizados e revisados. Mas fico surpreso que a rotineira atualização e revisão resultem em grandes diferenças como vistas aqui. Parece como se a curva tivesse sido reajustada em algum estágio, mas é então um pouco estranho que a curva representando a cobertura de nuvens baixas não parece ter sido rescalonada: as diferenças entre o máximo e o mínimo é de cerca de 3% e ambas figuras (é chato que os eixos verticais para a cobertura de nuvens são dados em unidades diferentes na Fig.2& 3). Será isso importante? Não sei. Mas pode ser um sinal de um trabalho mal feito. Não há informação suficiente sobre a metodologia para que eu pudesse repetir os resultados apresentados aqui.

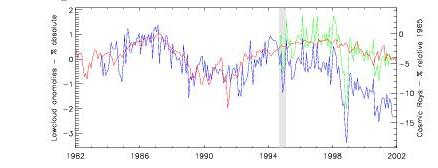

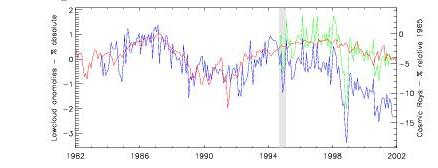

Svensmark certamente deve ter ajustado os dados de nuvem também. Acima é mostrada uma figura de um artigo anterior no qual ele justifica um ajuste de uma quebra na diferença entre nuvens baixas e altas. A questão é: por que o erro estaria nas medidas de nuvens baixas e não nas de nuvens altas? Eu não tenho visto quaisquer outras declarações independentes sobre quebras ou problemas na série de dados para nuvens baixas depois de ~1995. Apparentemente, existem algumas tendências nos dados do ISCCP, e Stordal et al. (2005) sugere que existe uma marca espúria do METEOSAT impressa nas nuvens altas (cirrus), e os problemas com as tendências do ISCCP estão agora se tornando bem conhecidas. Junto a isso, o erro fundamental que Marsh e Svensmark fizeram em suas 'correções' foi já discutido, mas como essa questão continua reaparecendo, o 'ajuste' é novamente mostrado (esquerda) enquanto que o 'ajuste' não pode ser discernido em gráficos independentes nos dados mais recentes (direita, e uma segunda opinião vizualizada numa análise independente de K. Gislefoss).

No artigo da A&G article, os GCR seriam responsáveis pelos episódios de 'bola de neve da Terra', e Svensmark escreve:

Um surpreendente produto dessa linha de questionamento é uma nova perspectiva da mudança do destino da vida ao longo dos últimos 3,5 bilhões de anos.

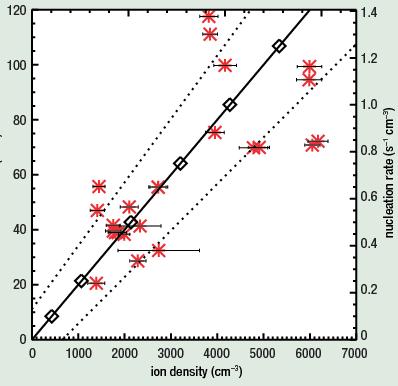

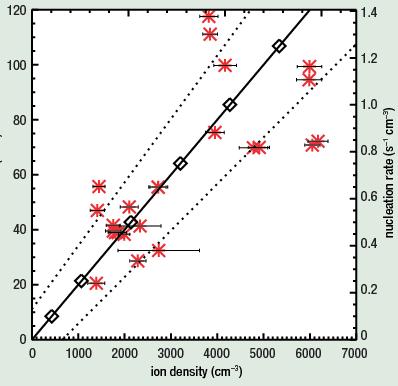

Além disso, o artigo pretende explicar o 'paradoxo solar fraco', pela completa ausência de nuvens baixas pois alegadamente não havia nenhum GCR naquele tempo. Presumivelmente, isso é levado a sério. Propor que os GCR sejam o único fator afetando nuvens baixas é inconsistente com o resultado mostrado na muito sua Fig. 4 (a plotagem mostrada à esquerda). No artigo da A&G, a Fig 4 realmente não mostra a relação entre GCR e nuvens, mas entre densidade iônica e os números de ultra-pequenos (raio superior a 3 nanometros) aerossóis de nucleação. A grande dispersão sugere que o número de aerossóis ultra-pequenos é muito fracamente afetado pelo número de ions – do contrário, todos os pontos situariam-se próximos à linha diagonal. Isso implica em outros fatores que devem influenciar a formação de aerossóis em adição a algum efeito devido à ionização. E isso é somente no ambiente de laboratório – fora da câmara de teste de Svensmark mais fatores devem desempenhar algum papel.

Além disso, o artigo pretende explicar o 'paradoxo solar fraco', pela completa ausência de nuvens baixas pois alegadamente não havia nenhum GCR naquele tempo. Presumivelmente, isso é levado a sério. Propor que os GCR sejam o único fator afetando nuvens baixas é inconsistente com o resultado mostrado na muito sua Fig. 4 (a plotagem mostrada à esquerda). No artigo da A&G, a Fig 4 realmente não mostra a relação entre GCR e nuvens, mas entre densidade iônica e os números de ultra-pequenos (raio superior a 3 nanometros) aerossóis de nucleação. A grande dispersão sugere que o número de aerossóis ultra-pequenos é muito fracamente afetado pelo número de ions – do contrário, todos os pontos situariam-se próximos à linha diagonal. Isso implica em outros fatores que devem influenciar a formação de aerossóis em adição a algum efeito devido à ionização. E isso é somente no ambiente de laboratório – fora da câmara de teste de Svensmark mais fatores devem desempenhar algum papel.

No experimento de laboratório 'SKY', a luz UV (ultravioleta) foi modulada para mimetizar a variação do sol, mas não ficou claro se os efeitos observados devido às mudanças no UV podem ser tranferidos aos GCR. O experimento também envolveu GCR naturais (em oposição a um feixe de partículas que presumivelmente seria mais fácil de controlar), suplementado com raios gama. Os aerossóis foram, de acordo com o artigo, grupos ultra-pequenos estáveis de ácido sulfúrico. Então, o que dizer dos grandes aerossóis que têm um papel na formação das nuvens? De acordo com "Atmospheric particles and nuclei" de Götz et al. (1991), Junge (1963) propôs, baseado em medidas de aerossóis, que partículas 'grandes' e 'gigantes' (raio maior que 0.1 micrômetro) constituem a maioria dos CCN, independentemente de sua composição química. Ao lado disso, a curva de Köhler (veja também aqui) baseada no trabalho teórico de 1926 e adiante indica que as gotas somente começam a crescer espontaneamente a partir de um certo tamanho crítico (elas são todas 'supercríticas'). O número de aerossóis sulfúricos é também influenciado pela disponibilidade de enxofre em geral. A quantidade de enxofre pode variar, por exemplo, com a queima de combustíveis fósseis, erupções vulcânicas, bem como devido à atividade biológica (i.e. através da emissão de dimetil sulfito ou 'DMS'; Götz et al. ,1991, p. 108), e presumivelmente o número de grupos de ácido sulfúrico formado nos últimos bilhões de anos pode ter sido afetado por diversos fatores geológicos. Aliado a isso, a pressão de vapor (ou 'supersaturação') deve realmente controlar se uma nuvem forma gotas ou não, visto que os aerossóis tendem estar casualmente ao redor. Tenho também algumas questões gerais sobre as evidências isotópicas de tempos pré-históricos. Seriam os isótopos de tempos passados criados somente por GCR bombardeando a atmosfera terrestre ou poderiam haver outras fontes? Algumas poderiam ser introduzidas por impactos de meteoritos/asteróides, atividades vulcânicas ou emissão distinta de gás radônio originado no interior da Terra?

Eu esperaria um fraco efeito do albedo das nuvens sobre as regiões cobertas de neve/gelo da Antarctica, mas Svensmark argumenta que a temperatura das nuvens aumentaria (esquentaria) ao invés de diminuir (resfriar). Esta declaração não é quantificada. Estará ele sugerindo algum efeito de gas de efeito estufa atuando durante os invernos Antárticos? Estaria o senso/cronologia de causa realmente determinado? O que dizer da temperatura afetando a cobertura de nuvens (por exemplo por advecção de ar suave e úmido) e o papel dos padrões de circulação? Certamente não há uma simples relação unidirecional. Acho que o artigo da A&G seja um pouco displicente sobre a complexidade envolvida nos processos atmosféricos. Essa atitude displicente parece ser uma marca registrada da cosmoclimatologia.

Presumo que muitos corpos celestes e cálculos complicados de gravitação tornam a modelagem da dinâmica de galáxias muito difícil, e os processos de formação de estrelas devem ter alterado a distribuição de massa e, assim, do campo gravitacional. Então, a dinâmica de estrelas durante bilhões de anos poderia ser certamente caracterizada como sendo caótica? Será mesmo possível reconstruir as constelações e a trajetória de nosso sistema solar ao redor da galáxia há mais de 2 bilhões de anos atrás com uma precisão que precede aquela de calcular o efeito do aumento da concentração de gases de efeito estufa nos dias atuais? Será a estória tão simples quanto narrada por Svensmark? Ele mesmo sugere que suas idéias são uma mudança de paradigma, o que 'cientificamente falando' seja tão seguro quanto a prevalência do paradigma do aquecimento global antropogênico (sigla em inglês, AGW). Eu vejo essa extensa declaração um pouco nebulosa dado que nenhuma qualificação seja feita sobre a questão AGW. Quais seriam exatamente os pontos fracos do paradigma AGW? Me pergunto se Svensmark sabe do que está falando.

É possível que os GCR de fato apresentem um efeito sobre o clima através da modulação das nuvens, mas eu não creio que seja muito forte. Também penso que as declarações de Svensmark são muito exageradas, mas em geral minhas objeções situam-se na forma como os argumentos são apresentados no artigo da A&G. Tenho a impressão que o trabalho da A&G vem da mesma escola do "O Ambientalista Cético ", que também tem sido criticado por referências pontualmente escolhidas para tornar mera especulação como solidamente fundamentada. Ignorar aspectos que não se adequam a hipótese não é ciência definitivamente. Do mesmo modo não é ajustar os dados de modo a dar um bom resultado sem uma sólida e convincente justificativa. A Ciência, todavia, significa objetividade, transparência, repitabilidade, e em princípio a possibilidade de falsificação. Além disso, seria somente uma falta de respeito com os leitores publicar um artigo que não contemple todos os lados relevantes da estória. Espero que Svensmark leia meus cometários e os responda aqui no RealClimate. Também espero que isso tudo seja lido por alunos e jornalistas que iniciam perguntas das questões críticas. Não sei a resposta para essas questões que postei aqui, assim gostaria de saber suas visões.

Agradecimentos

Agradeço Jørn Kristiansen pelos comentários e contribuições para essa minha postagem e Kristian Gislefoss por uma figura global da cobertura de baixas nuvens.

Fonte: RealClimate

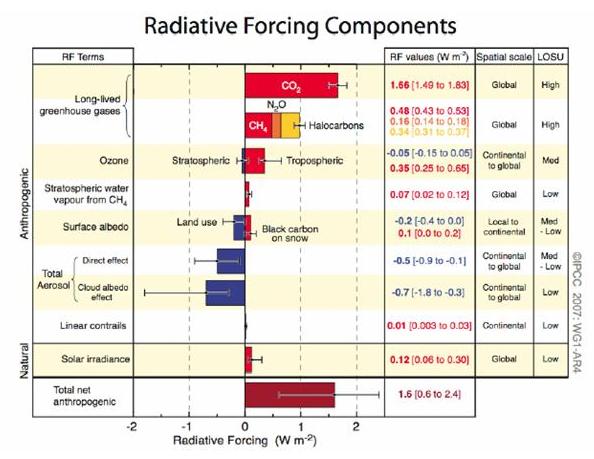

Figura SPM-2, mostrada aqui, compara a forçante radiativa para gases de efeito estufa e outros agentes, junto com uma avaliação do nível de entendimento científico (cuja sigla em inglês é LOSU), para cada componente. Nesta figura, está claro que os aerossóis contribuem com a maior forçante negativa (resfriamento), e que seu nível de entendimento varia de “baixo” a “meio baixo”. Os efeitos dos aerossóis se dividem em duas categorias: (1) efeitos diretos, relativos ao espalhamento ou à absorção da radiação pelos aerossóis, influenciando a quantidade líquida de energia que chega à superfície da Terra, e (2) efeitos indiretos, como o albedo das nuvens, referindo-se a como a presença dos aerossóis aumenta a refletividade de nuvens ao proporcionar um número maior de núcleos para a formação de gotas, reduzindo a quantidade de energia que chega a superfície. Isto já representa um passo a frente com relação ao último relatório, , onde o LOSU para os aerossóis variava de muito baixo a baixo, e nenhum valor mais provável era assinalado para a parte “indireta”.

Figura SPM-2, mostrada aqui, compara a forçante radiativa para gases de efeito estufa e outros agentes, junto com uma avaliação do nível de entendimento científico (cuja sigla em inglês é LOSU), para cada componente. Nesta figura, está claro que os aerossóis contribuem com a maior forçante negativa (resfriamento), e que seu nível de entendimento varia de “baixo” a “meio baixo”. Os efeitos dos aerossóis se dividem em duas categorias: (1) efeitos diretos, relativos ao espalhamento ou à absorção da radiação pelos aerossóis, influenciando a quantidade líquida de energia que chega à superfície da Terra, e (2) efeitos indiretos, como o albedo das nuvens, referindo-se a como a presença dos aerossóis aumenta a refletividade de nuvens ao proporcionar um número maior de núcleos para a formação de gotas, reduzindo a quantidade de energia que chega a superfície. Isto já representa um passo a frente com relação ao último relatório, , onde o LOSU para os aerossóis variava de muito baixo a baixo, e nenhum valor mais provável era assinalado para a parte “indireta”.

Numa recente edição da

Numa recente edição da

Além disso, o artigo pretende explicar o '

Além disso, o artigo pretende explicar o '